从Hadoop与MapReduce到淘宝架构 海量数据处理的演进与实践

在当今的信息化社会,数据已如潮水般涌现,其规模之大、种类之多、产生速度之快,对传统数据处理技术构成了前所未有的挑战。海量数据处理不仅是技术问题,更是驱动商业智能、科学研究和日常应用的核心引擎。本文将从经典的Hadoop框架与MapReduce编程模型出发,探讨其核心思想,并进一步剖析以淘宝技术架构为代表的现代互联网企业如何演化其数据处理与存储服务体系,以适应瞬息万变的业务需求。

一、基石:Hadoop框架与MapReduce模式

海量数据处理的早期系统性解决方案,绕不开Apache Hadoop。其核心设计哲学是“移动计算而非数据”。面对PB级甚至更庞大的数据集,网络带宽成为瓶颈,Hadoop通过将计算任务分发到数据所在的节点,极大地减少了数据传输开销。

- HDFS(Hadoop分布式文件系统):作为存储基石,HDFS将大文件分割成固定大小的数据块(Block),并以多副本形式分布式存储在集群的普通机器上。其高容错性和高吞吐量的特性,为上层计算提供了稳定的数据存储服务。

- MapReduce编程模型:这是Hadoop最初的计算引擎。其将复杂的数据处理任务抽象为两个核心阶段:

- Map(映射):任务被分割并分发到各数据节点,每个节点并行处理本地数据,生成一系列中间键值对(Key-Value)。

- Reduce(归约):将Map阶段产生的所有中间结果,按照Key进行排序、分组,并分发到Reduce节点进行聚合计算,最终输出结果。

MapReduce模型简单而强大,特别适用于批处理任务,如日志分析、网页索引构建等。它将并行计算、容错、数据分发等复杂性隐藏于框架之内,让开发者能够专注于业务逻辑。其“批处理”的天性也带来了延迟高、迭代计算效率低等局限性。

二、进化:超越批处理的实时化与多样化

随着电商、社交等业务的爆炸式增长,对数据处理的实时性、复杂性和灵活性提出了更高要求。以淘宝为代表的互联网巨头,其技术架构经历了从单一Hadoop体系向混合式、分层化数据处理栈的深刻演进。

淘宝的海量数据处理与存储服务架构,可以看作一个多层次、多引擎协同的生态系统:

- 存储服务层:统一与分化并存

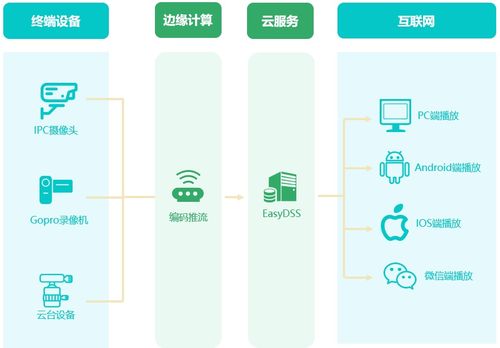

- 对象存储(如OSS):用于存储海量的非结构化或半结构化数据,如图片、视频、前端静态资源等,提供高可靠、低成本、无限扩展的存储能力。

- 分布式文件系统:在HDFS基础上,可能根据业务特点进行深度定制或引入新系统,以支持更大规模、更高性能的批处理数据存储。

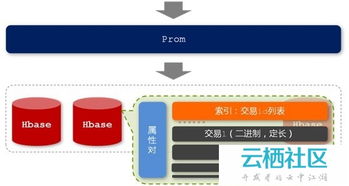

- NoSQL数据库(如HBase、Lindorm):为满足高并发、低延迟的在线查询需求,例如用户画像实时查询、订单状态快速读取,采用了面向列的分布式数据库,它们能提供毫秒级的随机读写能力。

- NewSQL/分布式关系数据库:对于需要强一致性事务的核心业务(如交易、库存),则依赖自研或优化的分布式关系型数据库,在保持ACID特性的前提下实现水平扩展。

- 计算服务层:批流一体与场景化引擎

- 批处理引擎:Hadoop MapReduce 逐渐被计算效率更高的 Spark 所补充或替代。Spark利用内存计算和更丰富的算子(RDD、DataFrame),在迭代计算、交互式查询上性能提升显著,依然是海量历史数据分析的主力。

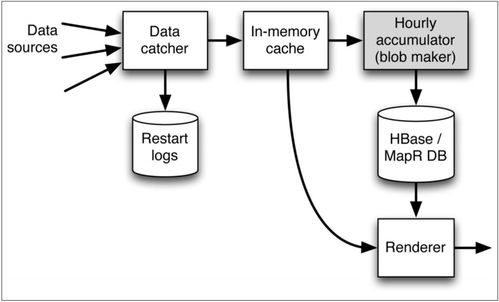

- 流处理引擎:为应对实时监控、实时推荐、风控等场景,Flink 和 Storm 等流计算框架被广泛采用。它们能处理无界数据流,实现秒级甚至毫秒级的延迟,让“数据价值”随时间流逝而衰减最小化。淘宝的“实时数据平台”正是构建于此之上。

- 交互式查询引擎:如 Presto/Trino、Impala 等,提供对海量数据的亚秒级到秒级的SQL查询能力,支持即席分析(Ad-hoc),赋能运营和决策人员。

- 搜索与推荐引擎:这是业务驱动的特化计算系统。基于倒排索引、向量检索等技术,构建了能够处理千亿级商品和用户行为的实时搜索与个性化推荐系统。

- 资源调度与协调层

- YARN 与 Kubernetes:YARN作为Hadoop2.0的核心,统一管理集群资源,支持多计算框架(MapReduce, Spark, Flink)混部。而现代架构中,容器化技术如Kubernetes正日益成为资源调度和应用部署的新标准,提供更灵活、更高效的资源管理与隔离。

三、架构思想:从工具组合到平台化服务

淘宝的技术架构演进,清晰地反映了海量数据处理领域的发展趋势:

- 从单一到融合:从依赖Hadoop批处理一套体系,发展为“批处理+流处理+交互查询+事务处理”多模融合的架构,根据数据特性和业务时效性选择最佳路径。

- 从中心化到服务化:数据处理能力不再是一个封闭的技术栈,而是以平台即服务(PaaS)或数据即服务(DaaS)的形式提供。内部用户可以通过标准接口(如SQL、API)便捷地获取存储、计算和分析能力,无需关注底层基础设施的复杂性。

- 从离线到实时:“实时化”成为核心竞争力。数据管道从传统的T+1日级延迟,进化到分钟级、秒级甚至毫秒级,使得实时决策、实时营销成为可能。

- 从计算存储耦合到分离:借鉴“存储计算分离”的云原生思想,计算资源和存储资源可以独立扩展,提升了整体的资源利用率和系统灵活性。

###

从Hadoop MapReduce的开山辟地,到淘宝等互联网企业构建的复杂、高效、实时的数据处理生态系统,海量数据处理技术的发展史,是一部不断应对挑战、突破极限的创新史。其核心驱动力始终是业务需求。随着人工智能的深度融合、云原生技术的普及以及硬件(如存算一体芯片)的革新,海量数据处理架构必将朝着更智能、更弹性、更高效的方向持续演进。理解从经典模式到现代架构的演变逻辑,对于设计下一代数据平台至关重要。

如若转载,请注明出处:http://www.ad-bdd.com/product/51.html

更新时间:2026-02-28 16:47:08